Python搭建Spark分布式集群环境

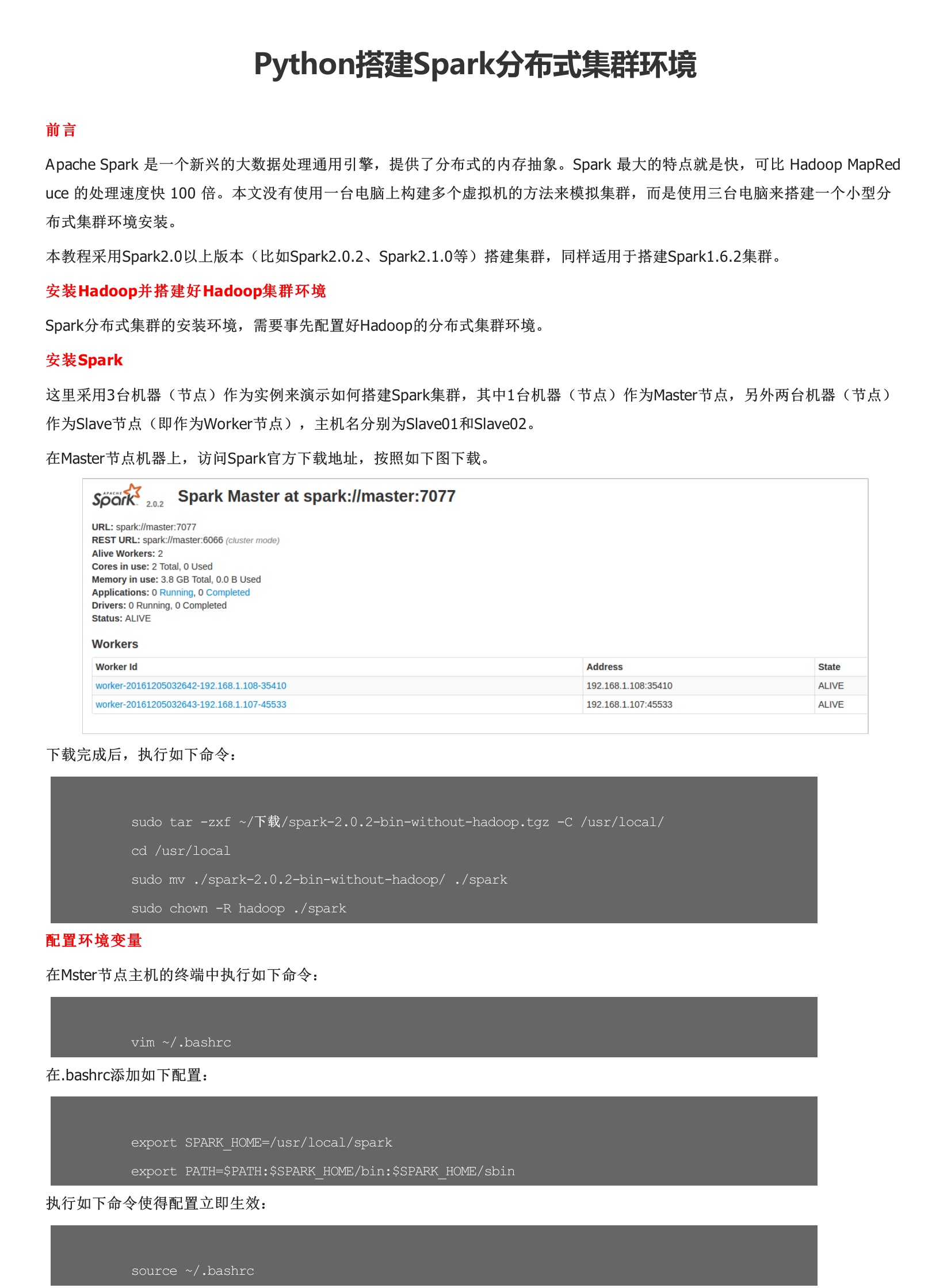

Apache Spark 是一个新兴的大数据处理通用引擎,提供了分布式的内存抽象。Spark 最大的特点就是快,可比 Hadoop MapReduce 的处理速度快 100 倍。本教程采用Spark2.0以上版本搭建集群,同样适用于搭建Spark1.6.2集群。Spark分布式集群的安装环境,需要事先配置好Hadoop的分布式集群环境。这里采用3台机器(节点)作为实例来演示如何搭建Spark集群,其中1台机器(节点)作为Master节点,另外两台机器(节点)作为Slave节点,主机名分别为Slave01和Slave02。在Master节点机器上,访问Spark官方下载地址,按照如下图下载。在Master主机上执行如下命令:在slave01,slave02节点上分别执行下面同样的操作:启动Spark集群前,要先启动Hadoop集群。

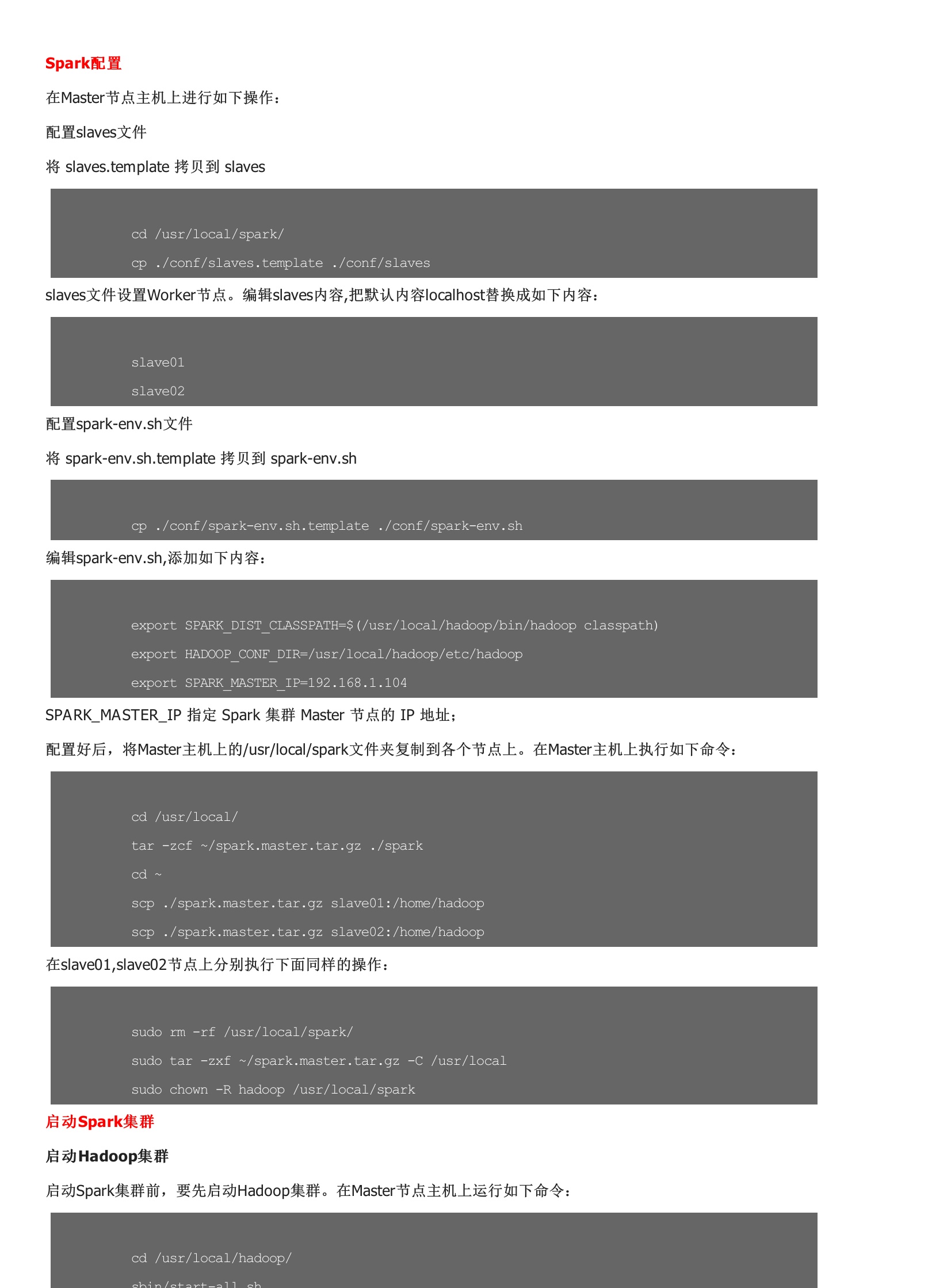

下载地址

用户评论